Journal de Comunicación Social 13(21), 89-111 agosto-diciembre de 2025 ISSN impresa 2412-5733; ISSN online 2413-970x DOI: https://doi.org/10.35319/jcomsoc.2025211331

Uso ético e integridad de la inteligencia artificial generativa en Bolivia

Ethical Use and Integrity of Generative Artificial Intelligence in the Context of Bolivia

Víctor Hugo Perales Miranda

Instituto de Investigaciones Sociológicas “Mauricio Lefebvre”, Universidad Mayor de San Andrés, La Paz, Bolivia

https://orcid.org/0000-0001-5249-1188

victorhugo76@gmail.com

Resumen: El uso de la inteligencia artificial generativa (IAGen) en Bolivia plantea un debate ético incipiente. El artículo analiza este fenómeno desde la perspectiva de la razón instrumental de Max Horkheimer y la crítica de Jean-Jacques Rousseau al progreso tecnológico. La IAGen, al priorizar la eficiencia, corre el riesgo de vaciar el conocimiento de su valor, trivializar la autoría y el juicio crítico. Los estudios revelan una paradoja: la IAGen es vista como útil, pero genera preocupaciones éticas sobre sesgos y la deshonestidad académica. Por tanto, es urgente crear políticas y una alfabetización crítica que guíe su uso para complementar el pensamiento humano, sin reemplazarlo.

Palabras clave: Inteligencia artificial generativa, razón instrumental, autoría, juicio crítico, alfabetización crítica.

Abstract: The use of generative artificial intelligence (GenAI) in Bolivia presents a nascent ethical debate. The article analyzes this phenomenon from the perspective of Max Horkheimer’s instrumental reason and Jean-Jacques Rousseau’s critique of technological progress. By prioritizing efficiency, GenAI risks emptying knowledge of its inherent value and trivializing authorship and critical judgment. Studies reveal a paradox: GenAI is seen as useful, yet it raises ethical concerns about bias and academic dishonesty. Therefore, it is urgent to create policies and foster critical literacy to guide its use as a complement to human thought, not a replacement.

Keywords: Generative Artificial Intelligence, Instrumental Reason, Authorship, Critical Judgment, Critical Literacy.

I. Introducción: Un debate en construcción

El surgimiento y la rápida expansión de la inteligencia artificial generativa (IAGen) representan uno de los fenómenos tecnológicos y sociales más disruptivos de la contemporaneidad. Herramientas como ChatGPT, DALL·E y otras similares han trascendido el ámbito de la ciencia ficción para insertarse en la vida cotidiana, la educación y la investigación. Sin embargo, su omnipresencia no debe ser interpretada como un avance neutral o una simple mejora en la eficiencia. Más bien, la IAGen nos confronta con interrogantes fundamentales sobre la naturaleza del conocimiento, la autoría, la integridad académica y la dirección misma de la civilización. Este artículo se adentra en un análisis crítico y profundo de estas cuestiones, asumiendo una premisa rectora e innegociable: la IAGen es, y debe ser considerada siempre, como una herramienta que no puede ser coautora (Ansari, 2024; Etesse, 2024).

Para realizar este análisis en toda su complejidad, el presente informe se apoya en dos marcos filosóficos que, aunque distantes en el tiempo, ofrecen una crítica poderosa y pertinente al tipo de progreso que la IAGen encarna. En primer lugar, se utiliza la crítica de la razón instrumental de Max Horkheimer (1947/1973), quien desentrañó cómo la razón moderna se ha vaciado de contenido, volviéndose un mero medio para alcanzar la máxima eficiencia, sin un fin moral o existencial que la guíe. En segundo lugar, se recurre a la perspectiva de Jean-Jacques Rousseau (1750/2001) sobre el progreso tecnológico, tal como se expone en su Discurso sobre las ciencias y las artes, que advertía que la proliferación del conocimiento y la tecnología, lejos de ennoblecer a la humanidad, corrompe las costumbres y la aleja de la virtud.

La aplicación de estos marcos a la realidad de la IAGen tiene una particular relevancia para el contexto boliviano, un entorno donde el debate sobre el uso ético de estas tecnologías es aún incipiente. Al situar estas tensiones filosóficas y prácticas en un contexto específico, el informe busca no solo diagnosticar los desafíos, sino también ofrecer un punto de partida para una discusión pública e institucional informada. El análisis se nutre estrictamente de las fuentes de investigación provistas, que evidencian una tensión palpable: una percepción mayoritariamente positiva de la utilidad de la IA, pero acompañada de profundas preocupaciones éticas sobre la privacidad, el sesgo, la autoría y la falta de regulación. Es precisamente en esta brecha entre la promesa de la herramienta y sus riesgos latentes donde se encuentra el valor de una crítica filosófica que invite a la reflexión antes de que la adopción acrítica de la tecnología se consolide (Ansari, 2024; Benavides-Lara et al., 2025; Domínguez-Caiza, 2025; Law et al., 2025; Perezchica-Vega et al., 2024; Runcan et al., 2025).

II. La razón instrumental en su culminación tecnológica

II.1. La razón reducida a medio: La IAGen como epítome de la eficiencia

La obra de Max Horkheimer (1947/1973), Crítica de la razón instrumental, diagnosticó un profundo proceso de deshumanización en la civilización occidental, provocado por la supremacía de una forma de razón que ha renunciado a su capacidad de juzgar los fines últimos de la existencia. Para Horkheimer, la razón objetiva, que alguna vez sirvió como una guía moral y teleológica para determinar valores como la justicia o la libertad, fue suplantada por la razón subjetiva o instrumental. Esta última no se preocupa por el valor intrínseco de los objetivos, sino únicamente por encontrar los medios más eficientes y calculables para alcanzarlos.

La inteligencia artificial generativa puede ser vista como la manifestación más avanzada de esta racionalidad. Su esencia misma es puramente instrumental: su función es generar contenido (texto, código, imágenes) de la forma más rápida y eficiente posible, en respuesta a un prompt o una instrucción dada por el usuario. La inteligencia del modelo no reside en una comprensión genuina o un juicio moral, sino en su habilidad para procesar vastos volúmenes de datos y generar un resultado que se adecúe a la instrucción. Los estudios de caso provistos en las fuentes refuerzan esta visión. La investigación de Domínguez-Caiza (2025) muestra que la IAGen es valorada por el 72% de los investigadores por su utilidad para “análisis de datos” y para “detectar patrones complejos”, lo que subraya una valoración centrada en la eficiencia técnica. Del mismo modo, Perezchica-Vega et al. (2024) y Benavides-Lara et al. (2025) revelan que los docentes aprecian el potencial de la IAGen para ahorrar tiempo y para la creación de materiales, lo que nuevamente sitúa su adopción en una lógica de optimización y productividad.

Esta adopción instrumental, motivada por la eficiencia, revela un proceso de desubstancialización del pensamiento que Horkheimer anticipó. La IAGen, al ser un modelo estadístico, carece por completo de un marco de valores o de un juicio real. Su funcionamiento se basa en la predicción de la siguiente palabra o píxel más probable, no en un entendimiento o una conciencia. Por tanto, no solo es una herramienta que sirve a fines, sino que es una herramienta que, por su propio diseño, no puede tener fines propios. Esto la convierte en el epítome de la razón instrumental: un sistema que opera con la máxima eficiencia sin cuestionamiento alguno sobre el porqué de su existencia o de su producción.

II.2. De la verdad al cálculo de probabilidades: La desubstancialización de la verdad

Horkheimer (1947/1973) argumentó que la supremacía de la razón instrumental vacía la noción de verdad de su contenido objetivo. En lugar de ser un fin en sí misma, la verdad se reduce a un asunto de verificación empírica y a la clasificación de hechos y cálculo de probabilidades. Este proceso, que el autor observó en el positivismo y el pragmatismo del siglo XX, encuentra en la IAGen una manifestación técnica casi perfecta.

Los sistemas de aprendizaje automático, en los que se basan los modelos generativos, son, en esencia, una forma de inducción automatizada. Su inteligencia se basa en la identificación de patrones y la predicción de regularidades estadísticas a partir de conjuntos de datos masivos. La verdad de la IAGen no es una correspondencia con la realidad, sino un reflejo de la probabilidad: una respuesta es correcta si es la más probable según su modelo estadístico, no si se corresponde con un valor objetivo o una causalidad real.

La falta de una comprensión causal subyacente es un elemento crítico en este análisis. Como explica Larson (2022) a partir del trabajo de Judea Pearl, el aprendizaje automático opera en el nivel más bajo de la escalera de causalidad: el de la mera asociación. Un modelo de lenguaje puede correlacionar la palabra “democracia” con la palabra “libertad” porque aparecen con frecuencia juntas, pero carece de una comprensión de la estructura causal que las une en el mundo social. El texto de Ansari (2024), al advertir que el uso descontrolado de la IAGen en la investigación puede fomentar una dependencia que debilita la capacidad crítica, evidencia este riesgo. La trivialización de la investigación a través de inferencias acríticas, reproducidas mecánicamente es una consecuencia directa de la reducción de la verdad a una mera asociación estadística.

Este proceso tiene implicaciones profundas para la producción de conocimiento. El saber deja de ser una búsqueda de las causas y los fines para convertirse en la simple organización de datos, lo que Horkheimer (1947/1973) llamó la “desubstancialización” del pensamiento. La IAGen no solo es una herramienta que sirve a fines preestablecidos, sino que es una herramienta que, por su diseño, no puede tener fines propios ni comprender las causas. Su inteligencia reside en la calculabilidad y la probabilidad, no en la sabiduría. En este contexto, la afirmación de que “la justicia y la libertad son de por sí mejores que la injusticia y la opresión” no sería científicamente verificable para la IAGen, ya que todo juicio se somete a la ciencia, concebida como “cálculo de probabilidades”.

La cosificación del pensamiento y el ocaso de la individualidad

Horkheimer (1947/1973) lamentó cómo la razón instrumental cosifica (o reifica) las obras de arte y las actividades humanas, convirtiéndolas en “mercancías culturales” y diluyendo su valor intrínseco. Al ser capaz de generar arte, texto, música o código de manera automática, la IAGen lleva este proceso de reificación a su extremo, despojando a la obra de su conexión con la experiencia, el juicio y la lucha del creador humano. La creatividad se convierte en un producto replicable, un kitsch tecnológico que, en palabras de Milan Kundera (1994/2003), simplifica ideas complejas y ofrece soluciones fáciles, suprimiendo el debate profundo.

Esta estandarización de la expresión, evidenciada por la capacidad de las herramientas generativas para imitar estilos o formatos predefinidos, contribuye a la “disolución de la individualidad” que Horkheimer (1947/1973) advirtió. Al ofrecer modelos y patrones para la creación, la IAGen puede fomentar la adaptación y el mimetismo en lugar de que tiene confianza natural en la autoridad, sino como un adulto que abandona la individualidad que ha conquistado” (Horkheimer, 1973, p. 110). La IAGen, al proveer medios para imitar y replicar estilos y contenidos, refuerza esta pasividad y la “disposición de ánimo que nos obliga a privarnos de toda sensación o de todo pensamiento que pudieran perjudicar nuestra celeridad frente a las exigencias impersonales que nos asaltan” (Horkheimer, 1973, p. 108).

En este marco, la premisa de que la IAGen no es un coautor es filosóficamente crucial, puesto que reafirma el valor irremplazable de la agencia, el juicio y la responsabilidad humana en la creación de conocimiento (Ansari, 2024; Etesse, 2024). La guía de Etesse (2024) subraya este punto al insistir en que la IAGen es un asistente que no reemplaza el juicio crítico ni la interpretación del investigador, quien es el único responsable de la validez del análisis. Esta distinción, que es el centro del debate ético, es una defensa del valor intrínseco del pensamiento humano frente a la tentación de la automatización.

III. El progreso tecnológico como causa de la decadencia moral

III.1. El origen vicioso de una herramienta “noble”: una lectura rousseauniana de la IAGen

Jean-Jacques Rousseau (1750/2001), en su Discurso sobre las ciencias y las artes, lanzó una crítica radical a la Ilustración al argumentar que el progreso intelectual y artístico, lejos de ennoblecer a la humanidad, corrompe las costumbres y fomenta los vicios. Para Rousseau, la ciencia y la tecnología no nacen de la virtud, sino de los defectos de su origen: la astronomía de la superstición, la elocuencia de la ambición y la mentira, la física de la vana curiosidad, e incluso la moral del orgullo humano.

Aplicando esta crítica al fenómeno de la IAGen, se puede argumentar que su desarrollo no surge de una búsqueda desinteresada de la verdad o de una necesidad humana fundamental, sino de los mismos vicios que Rousseau identificó: la vana curiosidad, la ambición de dominar y la avaricia. El motor de su desarrollo no es la verdadera filosofía que nos enseña nuestros deberes, sino el furor por distinguirse y la búsqueda de un nuevo lujo intelectual. La herramienta responde a la demanda de eficiencia, de ahorrar tiempo, y a la ociosidad que, según Rousseau (1750/2001), es un gran mal y la fuente de muchos vicios.

Si la IAGen automatiza gran parte del trabajo intelectual, puede fomentar una sociedad más ociosa, donde los individuos se vuelvan meros consumidores pasivos de contenido generado por máquinas, en lugar de productores activos y comprometidos. La crítica de Ansari (2024) sobre la “trivialización de la investigación rigurosa” entre los estudiantes, que debilita sus competencias clave, es una manifestación directa de este fenómeno. La IAGen, en esta lectura, valora el talento simulado (la capacidad de generar un texto o una imagen “perfecta”) sobre la virtud del esfuerzo (el juicio crítico, la reflexión, la investigación rigurosa). Esto invierte el orden moral de Rousseau, donde la virtud es superior al talento.

III.2. La simulación de la virtud y la corrupción de las costumbres

Rousseau (1750/2001) lamentaba la “vil y engañosa uniformidad” que el progreso impone, donde “nadie se atreve ya a parecer lo que es”. La IAGen, al generar respuestas o creaciones que son indistinguibles de las humanas, lleva esta uniformidad a un nuevo nivel. Las fuentes señalan la preocupación sobre el plagio, la desinformación y la credibilidad epistemológica de los contenidos, que son la manifestación contemporánea de la falsedad que Rousseau temía.

La IAGen crea una simulación de conocimiento y creatividad. Puede producir la apariencia de todas las virtudes sin tener ninguna. La guía de Etesse (2024) propone la estrategia de un circuito cerrado de información como medida para mitigar este riesgo, pero su misma necesidad revela el peligro subyacente: la herramienta puede confundir la apariencia con la sustancia. Esta capacidad de simular la virtud y la autenticidad socava la confianza y el valor del conocimiento que es producto de un genuino esfuerzo humano. En este contexto, se hace difícil saber con quién nos enfrentamos, ya que las interacciones y creaciones podrían ser indistinguibles de las generadas por una máquina.

III.3. La trivialización del conocimiento y la pérdida del juicio

Rousseau (1750/2001) criticaba la educación de su tiempo por enseñar “toda clase de cosas, salvo sus deberes”. La IAGen, al proporcionar soluciones prefabricadas, puede desviar a los estudiantes y a los investigadores de la labor fundamental del pensamiento crítico, la problematización y el análisis interpretativo. La investigación de Ansari (2024) y Perezchica-Vega et al. (2024) revela que, si bien la IAGen se adopta con entusiasmo, su uso no ha transformado los fundamentos de la práctica educativa. El uso instrumental de la herramienta, sin una formación crítica, la convierte en una simple muleta que evita el desarrollo de la autonomía y el juicio, que, para Rousseau (1750/2001), son esenciales para la virtud.

La IAGen, al igual que las “ciencias vanas” de Rousseau (1750/2001), podría “corromper nuestro juicio” al ofrecer respuestas convincentes sin la necesidad de un esfuerzo de discernimiento. La crítica de Larson (2022) sobre la falta de “abducción” (saltos creativos) en la IA es la justificación técnica de esta preocupación filosófica: la herramienta no ayuda a crear nuevas ideas, solo a recombinar las existentes, lo que sofoca la verdadera innovación y el juicio. El problema no es solo que la IAGen no posea abducción, sino que, al ofrecer respuestas prefabricadas, desincentiva el desarrollo de esta habilidad en los usuarios, lo cual es fundamental para el progreso del conocimiento y la inteligencia humana.

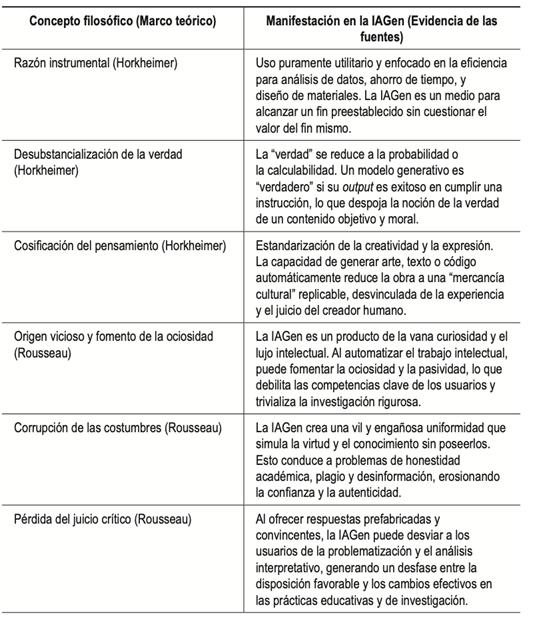

Tabla 1

Síntesis:

De la filosofía a la IAGen

Fuente: Elaboración propia

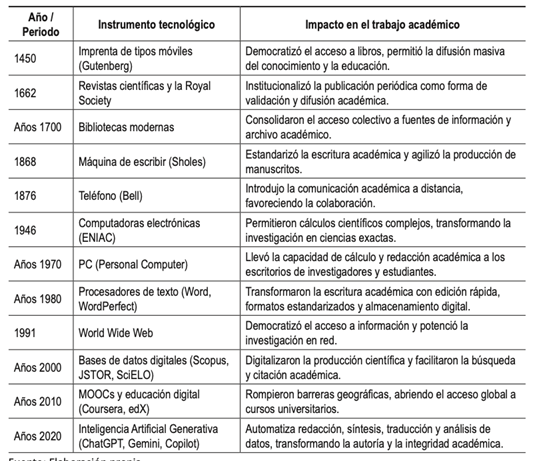

III.4. Viejas preocupaciones ético-filosóficas, viejas irrupciones tecnológicas en el mundo académico

La irrupción de la inteligencia artificial generativa (IAG) en el trabajo intelectual y académico no es un fenómeno aislado, sino la última iteración de un debate ético y filosófico con raíces profundas. Tal como el siglo XVIII vio en el progreso de las ciencias y las artes un potencial de corrupción moral, según la perspectiva crítica de Jean-Jacques Rousseau (1750/2001), hoy se reflexiona sobre si la IAGen es un instrumento que, lejos de ennoblecer el espíritu humano, exacerba una razón instrumental que valora la eficiencia sobre el fin mismo del conocimiento. Desde esta óptica, la preocupación no radica solo en la herramienta en sí, sino en el riesgo de que esta nos aleje de la reflexión profunda y la búsqueda de la verdad, reemplazándolas por una producción automática y desprovista de sentido.

Esta tensión entre la virtud y la técnica ha acompañado al trabajo académico a lo largo de la historia. Mucho antes de la IA, inventos como la imprenta de tipos móviles democratizaron el acceso a los libros y transformaron radicalmente la difusión del saber. De forma similar, la máquina de escribir (1868) y, más recientemente, los procesadores de texto de los años ochenta, cambiaron por completo la forma de redactar y producir textos académicos, estandarizando la escritura y agilizando la producción. Estos instrumentos, al igual que las bases de datos digitales o la World Wide Web, redefinieron la colaboración y la investigación, generando en cada etapa discusiones sobre la autenticidad, la autoría y la integridad del proceso intelectual, sin que por ello se frenara su adopción.

En este contexto, la IAGen se presenta no como un quiebre, sino como una aceleración sin precedentes de estas dinámicas históricas. Si bien los procesadores de texto transformaron la producción, la IAGen automatiza la creación de contenido, obligando a una reconsideración de la esencia de la autoría. Por ello, las preocupaciones éticas que hoy emergen –desde el plagio y la desinformación hasta la opacidad algorítmica– son ecos de debates filosóficos de siglos pasados, pero aplicados a una tecnología con una capacidad de intervención en el pensamiento humano sin parangón. La discusión en Bolivia, un país donde el debate es aún incipiente, se suma a esta conversación global que busca equilibrar el inmenso potencial de la tecnología con la preservación de los valores humanos y la integridad del conocimiento.

Tabla 2

Línea de tiempo de instrumentos tecnológicos que cambiaron el trabajo académico

Fuente: Elaboración propia.

De hecho, aunque la IAGen es un nuevo producto, su llegada ya había sido advertida por la literatura desde hace mucho, por ejemplo, aunque Borges (1941/1987), en su cuento “La Biblioteca de Babel”, no describe computadoras parlantes o algoritmos de escritura, conceptualiza un universo que ya ha “generado” todo el conocimiento y la ficción posibles a través de la combinación de símbolos. En este sentido, es una profunda meditación sobre la naturaleza de la información, el lenguaje y la creación, que toca directamente las implicaciones filosóficas de lo que hoy conocemos como inteligencia artificial generativa. Por otra parte, Phillip K. Dick (1968), en su novela distópica ¿Los androides sueñan con ovejas eléctricas?, menciona de forma recurrente un programa de televisión omnipresente en el universo de la novela: el Amigo Buster.

Asimismo, en la novela de Alison Spedding, De cuando en cuando Saturnina, se menciona explícitamente a un chatbot:

No es un fucking chatterbot, es para matar, no es para vender vacaciones en los Rocky Mountains”. Según yo veo es algo como un perro de caza muy sofisticado, y los perros cazan a la gente sin necesidad de hablar ¿no ves? Lo que tiene es pattern recognition, todos los modelos de nave que hay, orbitals, spacelugs, todo, igual todos los weapons systems, sus rastros en infrarrojo, luz visible. ultravioleta, señales de radio, y también todos los programas de defensa […] (Spedding, 2004, p. 150).

En esta obra, Spedding combina elementos de inteligencia artificial en situaciones de un contexto futuro, de ciencia ficción distópica en el escenario andino, casi unos 20 años antes de la aparición de ChatGPT.

IV. El debate incipiente en el contexto boliviano: diagnóstico y tensiones

IV.1. Un terreno fértil para la tensión filosófica

Los estudios empíricos sobre la percepción y el uso de la IAGen revelan una paradoja central que sitúa al contexto boliviano en un terreno de tensión filosófica. Existe una percepción mayoritariamente positiva sobre la utilidad de la IA, como señala Domínguez-Caiza (2025), con un 72% de los investigadores destacando su potencial para el análisis de datos y una amplia presencia de herramientas como ChatGPT entre la comunidad universitaria. Sin embargo, esta disposición favorable coexiste con una profunda preocupación ética por la privacidad de los datos, el sesgo algorítmico y la opacidad. Esta dualidad refleja, a nivel micro, el conflicto entre la razón instrumental y la razón objetiva que Horkheimer (1947/1973) describió. La adopción es motivada por la eficiencia y la utilidad (razón instrumental), pero las preocupaciones latentes apuntan a una necesidad de valores, justicia y fines últimos (razón objetiva).

Esta brecha entre la disposición favorable y la inercia institucional es un hallazgo crítico. Aunque los docentes se sienten capaces de incorporar la IAGen, la mayoría no ha modificado sus mecanismos de evaluación o sus prácticas pedagógicas para mitigar los riesgos, como el plagio. Esta falta de transformación sugiere un conflicto sistémico. Las instituciones, ancladas en modelos tradicionales de evaluación, no han logrado integrar un marco ético robusto que se preocupe por los fines del conocimiento, quedando rezagadas mientras los individuos adoptan la herramienta por su valor instrumental.

Las barreras estructurales, como la falta de formación técnica, el alto costo de implementación y las brechas de acceso, agravan las desigualdades preexistentes en el acceso al conocimiento. Esto genera un problema de equidad epistémica, donde quienes dominan los lenguajes técnico-algorítmicos tienen mayor capacidad de influir sobre las interpretaciones sociales legitimadas. Para el contexto boliviano, donde el debate es incipiente, esta tensión ofrece una oportunidad única para intervenir con políticas que busquen la reconciliación entre la eficiencia técnica y la integridad moral.

IV.2. Del “lavado ético” a la ética situada

El análisis de Runcan et al. (2025) critica la tendencia a adoptar principios éticos abstractos sin mecanismos de implementación reales, un fenómeno que se ha denominado “ethics washing”. Estos marcos, que a menudo son retóricos y carecen de mecanismos de fiscalización, tienen un sesgo epistémico que ignora las voces y los saberes no occidentales, haciendo que las soluciones sean irrelevantes para contextos como el boliviano. Si el desarrollo de la IAGen está dominado por visiones tecnocráticas y occidentales y la adopción en contextos como el boliviano es pasiva y sin la formación adecuada, la IAGen podría convertirse en un mecanismo para importar y solidificar un sesgo epistémico ajeno. El conocimiento producido, si es generado acríticamente con la herramienta, reproducirá y perpetuará los mismos sesgos culturales y epistemológicos que los marcos éticos dominantes no logran abordar.

Se argumenta, por tanto, la necesidad de una ética de la IA situada, adaptada a las realidades locales. Esto implica considerar los desafíos específicos de la región (brechas de acceso, costos) y co-crear marcos normativos que respondan a las dinámicas propias, en lugar de importar soluciones foráneas. Este enfoque proactivo, en lugar de una supervisión pasiva, busca diseñar esquemas normativos que sean inclusivos, adaptables y sensibles al contexto sociocultural, lo que es un llamado a la acción para el debate en Bolivia.

IV.3. El desafío de la integridad académica y el juicio humano

Las preocupaciones sobre la honestidad académica, el plagio y la autoría son un desafío directo a la integridad del proceso de investigación y aprendizaje. La IAGen, al generar contenidos que son indistinguibles de los humanos, hace que la distinción entre un aporte genuino y uno automatizado sea cada vez más difícil.

Ante esta realidad, la propuesta de Ansari (2024) de una declaración explícita de autoría para el contenido generado por IA se presenta como una medida crucial. Esta declaración permitiría distinguir entre los aportes genuinos del autor y aquellos que provienen de procesos automatizados, facilitando el escrutinio crítico del contenido y asegurando la transparencia. Al igual que en la bioética, donde el principio de beneficencia exige maximizar los beneficios y minimizar los daños, en la ética de la IA, el principio de rendición de cuentas (accountability) es vital para mantener la integridad, situando la responsabilidad legal, técnica y ética en el ser humano.

El papel irremplazable del juicio humano es el hilo conductor de toda la crítica. La IAGen no puede validar su propio contenido, ni puede responsabilizarse por sus efectos. Por tanto, el ser humano sigue siendo el único guardián de la validez y el significado. El principio de explicabilidad es fundamental en este sentido, dado que exige que los usuarios comprendan cómo se procesan los datos y cómo funcionan los algoritmos, lo que reduce el riesgo de delegar sin conciencia. La tesis central del artículo, que la IA es una herramienta y no un coautor (Ansari, 2024; Etesse, 2024), se reafirma como el principio rector para la integridad académica.

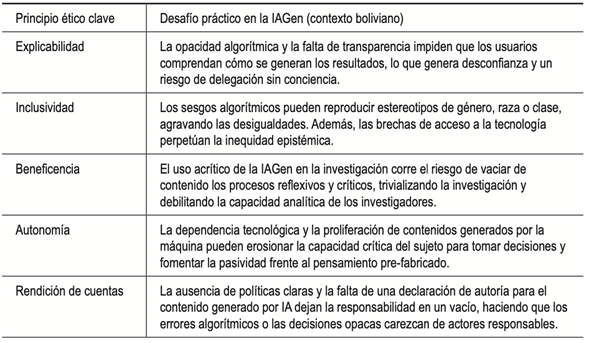

Tabla 3

Principios éticos de la IA vs. desafíos prácticos en el contexto boliviano

Fuente: Elaboración propia.

V. La IA generativa como herramienta de apoyo en la investigación: estado del arte

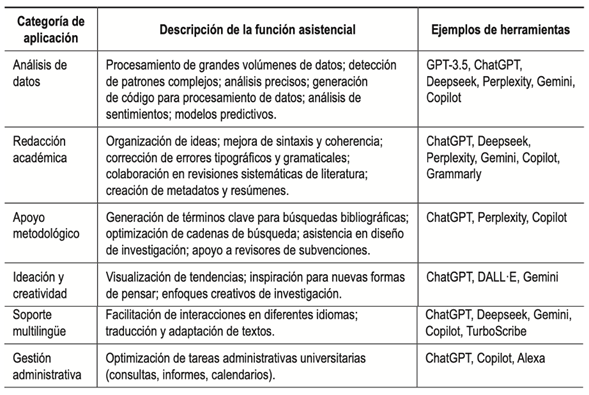

La inteligencia artificial generativa (IAGen) ha emergido como una herramienta transformadora en el ecosistema de la investigación académica, ofreciendo un abanico de aplicaciones que amplifican las capacidades humanas en diversas fases del proceso científico. Su rol se extiende más allá de la mera eficiencia operativa, actuando como un verdadero amplificador epistémico.

V.1. Ampliación de capacidades metodológicas y analíticas

La IAGen mejora significativamente el proceso de investigación al asistir en la recolección, el procesamiento y el análisis de datos. Tiene la capacidad de procesar grandes volúmenes de información, permitiendo la detección de patrones complejos que antes pasaban inadvertidos y generando análisis más precisos. Esta capacidad se extiende a la generación de código para el procesamiento de datos en diversos lenguajes de programación; por ejemplo, GPT-3.5 puede traducir código entre lenguajes sin errores de sintaxis, lo que agiliza y optimiza las tareas computacionales en la investigación.

Además, la IAGen es útil en el análisis en redes sociales y en la creación de modelos predictivos para fenómenos sociales complejos, como resultados electorales o escenarios de salud pública. Estas aplicaciones demuestran su utilidad tanto en el análisis cuantitativo como en el cualitativo, al permitir a los investigadores manejar y extraer sentido de conjuntos de datos masivos. La capacidad de la IAGen para reformular preguntas de investigación y expandir las formas de interpretar fenómenos sociales indica que su impacto va más allá de la eficiencia operativa; puede influir sutilmente o incluso expandir los objetivos mismos de la investigación, empujando los límites de la indagación y permitiendo a los investigadores explorar nuevas fronteras cognitivas y analíticas.

V.2. Colaboración en la redacción y revisión académica

La IAGen se ha consolidado como un colaborador potente en la escritura académica. Asiste en la organización de ideas, la mejora de la sintaxis y la coherencia, y la corrección de errores tipográficos y gramaticales. Esta función es particularmente valiosa para la adaptación de textos a diferentes idiomas, lo que se alinea directamente con las necesidades de apoyo lingüístico en investigaciones que requieren difusión internacional.

En el ámbito de las revisiones sistemáticas de literatura, la IAGen puede generar términos clave para búsquedas booleanas y optimizar cadenas de búsqueda bibliográfica, simplificando las fases iniciales de la investigación. Asimismo, contribuye a la difusión de nuevas ideas al crear metadatos, indexación y resúmenes mejorados de los resultados de investigación.

V.3. Potencial para la inspiración y el pensamiento creativo

Más allá de las tareas de eficiencia, la IAGen posee un potencial significativo para la inspiración y el pensamiento creativo. Puede visualizar tendencias y sugerir nuevas formas de abordar problemas, fomentando enfoques creativos en la investigación. Esto la convierte en una herramienta valiosa en la fase de ideación, ayudando a los investigadores a superar bloqueos conceptuales o a explorar perspectivas novedosas.

Adicionalmente, la IAGen puede asistir a los revisores de subvenciones al abordar consultas críticas sobre la novedad de una solicitud o las credenciales del investigador principal, mejorando la calidad y eficiencia del proceso de evaluación de proyectos.

V.4. Soporte multilingüe y optimización de tareas administrativas

El soporte multilingüe que ofrece la IAGen es notable, facilitando las interacciones en diferentes idiomas y asegurando una comunicación clara y fiable, independientemente de la lengua utilizada. Esta capacidad es directamente relevante para la investigación que opera en contextos internacionales o que busca una amplia difusión de sus hallazgos.

En un sentido más amplio, la IAGen también optimiza tareas administrativas en el entorno universitario, como la reducción de tiempos de respuesta a consultas, la elaboración de informes y la gestión de calendarios. Aunque estas funciones no son directamente investigativas, liberan recursos humanos que pueden ser reorientados hacia actividades más sustantivas de investigación.

La integración de la IAGen en la investigación no se limita a hacer las tareas existentes más rápidas o eficientes. Sus capacidades para procesar vastas cantidades de información, identificar patrones complejos y sugerir nuevas perspectivas implican que la IAGen puede reformular preguntas de investigación y ampliar las formas de interpretar fenómenos sociales. Esto significa que la IAGen no es solo un medio para un fin preexistente; puede influir o incluso expandir los fines de la investigación misma. Esta función transformadora convierte a la IAGen en un amplificador epistémico, capaz de extender el alcance y magnificar la capacidad del investigador humano, lo que exige una nueva forma de alfabetización epistémica para aprovechar su potencial mientras se mantiene la supervisión crítica. A continuación, se presenta una tabla que resume las aplicaciones asistenciales de la IAGen en la investigación, incluyendo ejemplos de herramientas y sus referencias:

Tabla 4

Herramientas de IA Generativa y sus aplicaciones asistenciales en la

investigación

Fuente: Elaboración propia.

VI. Desafíos éticos y riesgos de la IA generativa en la investigación académica

A pesar de las promesas de eficiencia y expansión de capacidades, la integración de la inteligencia artificial generativa (IAGen) en la investigación académica implica una serie de desafíos éticos y riesgos significativos que exigen una atención crítica y proactiva. La misma eficiencia que hace atractiva a la IAGen puede, paradójicamente, enmascarar vulnerabilidades epistemológicas y éticas.

VI.1. El fraude académico y la deshonestidad: una amenaza catalizada por la IAGen

La amenaza principal para la integridad académica es el fraude, un fenómeno que la IAGen cataliza y complejiza de manera considerable. El triángulo del fraude –oportunidad, incentivo y actitud– se ve exacerbado por la IAGen. La percepción de poder cometer fraude evitando la detección aumenta debido a la disponibilidad gratuita de numerosas aplicaciones y la elevada verosimilitud de los resultados, que pueden parecer fácilmente elaborados por estudiantes o investigadores. Los incentivos, como la finalización más rápida de tareas o la obtención de mejores calificaciones, se amplifican por la eficiencia de la IAGen en la producción de resultados de calidad.

Los docentes expresan un temor predominante a que la IAGen sea utilizada por los estudiantes para resolver exámenes y tareas, lo que afecta directamente la honestidad académica. Esta preocupación se extiende a la potencial trivialización de la investigación rigurosa, al debilitar la capacidad crítica y fomentar una dependencia que vacía de contenido los procesos reflexivos y metodológicamente fundamentados. Factores institucionales, como la admiración por los resultados de la IAGen, pueden llevar a una relajación de los mecanismos de lucha contra el fraude, priorizando la innovación sobre la integridad académica, lo que agrava aún más el riesgo.

VI.2. Contenido erróneo, sesgos algorítmicos y opacidad

La IAGen es susceptible de producir alucinaciones, es decir, contenido incorrecto o inexacto, atribuyendo autoría a autores inexistentes o citando fuentes ficticias. Estos resultados pueden parecer altamente convincentes, lo que representa un riesgo significativo de desinformación para usuarios que no ejercen un juicio crítico.

Una preocupación fundamental es el sesgo algorítmico. La IAGen puede generar resultados sistemáticamente distorsionados o incorrectos debido a defectos en el diseño o a la baja calidad/desactualización de los datos de entrenamiento, lo que perpetúa y amplifica prejuicios preexistentes (políticos, raciales, culturales, de género). Por ejemplo, los modelos de texto a imagen pueden reforzar estereotipos étnicos y género. La opacidad de los modelos de IAGen, donde los usuarios no pueden comprender completamente cómo se generan los resultados o qué datos se consideran, dificulta la evaluación de la corrección o validez de la salida. Esta falta de transparencia es un desafío ético mayor, ya que impide una auditoría crítica y la rendición de cuentas.

La eficiencia y la capacidad de la IAGen para generar contenido plausible rápidamente pueden llevar a una relajación de la vigilancia crítica por parte de los usuarios. Esta tendencia a aceptar los resultados generados sin una verificación humana suficiente o un escrutinio ético, precisamente por su velocidad y aparente convicción, crea una trampa algorítmica. En esta trampa, la principal fortaleza de la tecnología (su eficiencia) se convierte en una debilidad, ya que puede socavar el rigor epistemológico y la integridad ética de la investigación. Por tanto, un enfoque crítico y escéptico no es solo aconsejable, sino necesario para contrarrestar el atractivo inherente de la velocidad de la IAGen.

VI.3. Impacto en el pensamiento crítico y la originalidad

La dependencia excesiva de la IAGen puede llevar a la delegación del pensamiento, reduciendo las habilidades esenciales de los estudiantes y los investigadores en áreas como el pensamiento crítico, la creatividad, la escritura y la resolución de problemas. Esto podría obstaculizar el desarrollo intelectual a largo plazo y tener un impacto negativo en la calidad de la educación y la investigación.

Desde una perspectiva sociológica, la integración de la IA automatiza tareas que amenazan con desdibujar el papel del docente (y por extensión, del investigador) como constructor y curador del saber. Esto puede conducir a una desprofesionalización simbólica, donde el juicio se externaliza a sistemas técnico-cuantitativos, comprometiendo la función epistémica crítica del investigador.

VI.4. Preocupaciones por la privacidad de los datos y la propiedad intelectual

La privacidad de los datos es una preocupación significativa, con riesgos de re-identificación incluso en bases de datos anonimizadas, lo que plantea interrogantes sobre la seguridad de la información y el consentimiento informado. Las plataformas de IAGen a menudo operan con modelos opacos en cuanto al destino de la información proporcionada, lo que puede habilitar formas de vigilancia algorítmica o minería de datos educativos.

Las inquietudes sobre la propiedad intelectual surgen de la capacidad de la IAGen para reorganizar información preexistente sin el reconocimiento o la citación adecuados, lo que podría infringir derechos de autor. Demandas legales, como la de The New York Times contra OpenAI y Microsoft por el uso de datos protegidos por derechos de autor para el entrenamiento de modelos sin compensación, subrayan la complejidad legal en torno a la propiedad del contenido generado por IA.

VI.5. La fiabilidad de las herramientas de detección de contenido de IA

Una de las mayores controversias en el ámbito académico es la inexactitud y falta de fiabilidad de las herramientas diseñadas para detectar contenido generado por IAGen (como ZeroGPT o Turnitin). Estas herramientas tienen dificultades para identificar textos producidos por IAGen que sean ligeramente modificados o parafraseados por humanos.

Además, son propensas a falsos positivos, etiquetando erróneamente contenido genuinamente humano (incluso documentos históricos como la Constitución de EE. UU. o el libro del Génesis) como generado por IA, lo que implica el riesgo de acusaciones falsas. La propia herramienta de detección de OpenAI fue retirada debido a su baja precisión. Esta situación crea una “carrera armamentista” constante entre los desarrolladores de IAGen y las herramientas de detección, sin garantía de una detección fiable, lo que ha llevado a algunas universidades líderes a desaconsejar activamente su uso para casos de deshonestidad académica.

La continua evolución de la IAGen, que produce resultados cada vez más sofisticados, contrasta con las crecientes preocupaciones sobre sus limitaciones fundamentales, como la falta de comprensión real, pensamiento crítico, responsabilidad y originalidad. Esta situación revela una “paradoja de la integridad”: cuanto más avanza la tecnología, más se subraya el valor único e irremplazable del intelecto humano. La incapacidad de las herramientas de detección de IA para identificar de manera fiable el contenido generado por máquinas refuerza la idea de que la supervisión tecnológica es insuficiente y que la supervisión humana es primordial. Esto sugiere que la “crisis” provocada por la IAGen está, paradójicamente, impulsando una “re-humanización” de la investigación, obligando a la comunidad académica a articular con mayor claridad qué constituye la contribución intelectual humana y por qué sigue siendo indispensable.

La urgencia de establecer regulaciones, políticas claras y marcos éticos es un reflejo de que el rápido –y en gran medida no regulado– avance de la IAGen ha generado una brecha significativa entre la capacidad tecnológica y los mecanismos éticos y de gobernanza existentes para gestionarla. Este retraso normativo es una causa directa de muchos de los dilemas éticos actuales. Esto implica que los desafíos actuales no son meramente inherentes a la tecnología, sino que son una consecuencia de una deuda ética social y académica, es decir, una falta de proactividad en el establecimiento de marcos de gobernanza robustos a la misma velocidad con la que se desarrolla la tecnología. Abordar los desafíos éticos de la IAGen requiere no solo medidas reactivas, sino un compromiso proactivo con una gobernanza ágil y directrices vivas que puedan evolucionar con la tecnología.

VII. Respuestas institucionales y mejores prácticas para una integración responsable

Ante la rápida evolución y los desafíos inherentes a la inteligencia artificial generativa (IAGen), las instituciones académicas y los organismos reguladores han comenzado a desarrollar respuestas y a establecer mejores prácticas para una integración ética y responsable. La estrategia ha evolucionado de una postura inicial de prohibición a un enfoque más matizado de integración ética.

VII.1. Del prohibicionismo a la integración ética

Las reacciones iniciales a la IAGen fueron diversas, con algunas universidades optando por la prohibición total de su uso. Sin embargo, esta prohibición generalizada ha sido considerada poco realista, ineficaz y contraproducente para formar ciudadanos alfabetizados en IA, una competencia esencial para el futuro. La tendencia actual se inclina hacia el fortalecimiento de la integridad académica mediante la promoción de un uso adecuado y responsable de la IAGen, que contribuya positivamente al aprendizaje y a los resultados esperados, al tiempo que se guía o limita su uso en actividades evaluativas. Esto implica una redefinición necesaria de la integridad académica en el contexto de una educación cada vez más mediada por la tecnología.

El rápido avance de la IAGen ha superado el ritmo de desarrollo de políticas institucionales y directrices éticas. Este retraso normativo ha creado un vacío en el que la IAGen se adopta sin reglas claras, lo que genera incertidumbre y aumenta los riesgos, como la falta de medidas pedagógicas para mitigar el uso de IAGen en tareas y exámenes. La respuesta a este retraso es la adopción de directrices vivas y actualizaciones continuas, lo que implica que las políticas estáticas son insuficientes en un entorno tecnológico en constante cambio. Por consiguiente, una gobernanza efectiva de la IAGen en la academia requiere un marco ágil, adaptable y en constante evolución, donde las instituciones prioricen el desarrollo continuo de políticas para mantenerse al día con los avances tecnológicos y los desafíos éticos emergentes.

VII.2. Necesidad de políticas y directrices claras y específicas

La creciente adopción de la IAGen ha ejercido una presión significativa sobre las universidades para desarrollar políticas y directrices claras y fáciles de entender, específicamente para el uso de modelos de lenguaje en el aprendizaje y la enseñanza. Muchas de las guías existentes sobre IA son genéricas y no abordan adecuadamente los problemas específicos causados por la IAGen en la educación superior.

Universidades líderes como Stanford, Chicago, Princeton y Northwestern han comenzado a emitir directrices detalladas para profesores, estudiantes e investigadores, cubriendo usos permitidos, requisitos de citación y advertencias sobre las limitaciones de la IAGen. La Universidad de Hong Kong es reconocida por ser pionera en la implementación de políticas integrales de IA. Otros ejemplos incluyen la Universidad Politécnica de Cartagena, la Universitat Oberta de Catalunya y la Universidad Complutense de Madrid, que han adoptado declaraciones y directrices sobre el uso responsable y ético de la IAGen.

VII.3. Importancia de la alfabetización en IA y la formación ético-crítica

Existe una necesidad urgente de promover la alfabetización crítica en IA y la concientización entre investigadores, profesores y estudiantes sobre el uso ético y transparente de las tecnologías de IA. Esta alfabetización va más allá de la habilidad técnica, abarcando la capacidad de evaluar la calidad, veracidad y validez de la información generada por la IA.

La formación debe abordar el uso instrumental o superficial de la IAGen, la falta de alfabetización algorítmica y la ausencia de marcos pedagógicos apropiados. La guía global de la Organización de las Naciones Unidas para la Cultura, las Ciencias y la Educación (UNESCO, 2024) sobre la IAGen en la educación y la investigación enfatiza un enfoque multidisciplinario para la alfabetización en IA, centrado en los derechos humanos, la dignidad, la inclusión y la equidad. La necesidad de esta alfabetización se ha vuelto, más que una habilidad opcional, una competencia fundamental para el futuro, esencial para navegar el panorama académico y profesional moderno. Esto requiere que las instituciones integren programas de alfabetización en IA en sus planes de estudio y desarrollo docente.

VII.4. Rediseño de evaluaciones y enfoques pedagógicos

El auge de la IAGen exige un replanteamiento del currículo no solo en sus contenidos, sino también en sus lógicas pedagógicas, evaluativas y epistemológicas. Esto implica revisar qué se enseña, cómo se enseña y para qué se aprende.

Aunque se propusieron las “evaluaciones auténticas” como una salvaguarda contra el fraude, la investigación demuestra que no son inmunes a la manipulación por IAGen, y los evaluadores a menudo no pueden distinguir entre trabajos asistidos por IA y trabajos puramente realizados por humanos. Esta evidencia subraya la necesidad de un “diseño inteligente de la evaluación” en lugar de depender únicamente de la autenticidad o de herramientas de detección falibles. La falta de fiabilidad de las herramientas de detección de IAGen obliga a un cambio estratégico: si no se puede detectar de manera fiable el uso indebido, la prevención debe centrarse en el diseño pedagógico. Esto implica rediseñar las evaluaciones, los planes de estudio y los enfoques pedagógicos para hacer que el uso indebido de la IAGen sea menos atractivo o efectivo, y para fomentar habilidades que la IAGen no puede replicar, como el pensamiento crítico y la investigación original. La integridad académica en la era de la IAGen no se trata principalmente de detectar trampas mediante la tecnología, sino de crear un entorno educativo donde el aprendizaje genuino y el pensamiento crítico se valoren y fomenten intrínsecamente a través de un diseño pedagógico inteligente.

La tesis central es que la IAGen debe complementar, no reemplazar, a los actores educativos y sus capacidades, enfatizando el valor insustituible del juicio humano y la conexión pedagógica.

VII.5. Colaboración multidisciplinaria como condición estructural

Abordar la complejidad de la IAGen y el fraude académico requiere un enfoque sistémico que involucre a toda la comunidad universitaria y una colaboración multidisciplinaria robusta entre expertos de tecnología, derecho, sociología, educación y otros campos. Esta cooperación exige una “traducción conceptual” entre lógicas epistémicas distintas.

El enfoque de la ética embebida, donde investigadores sociales y éticos se integran en los equipos técnicos desde las etapas tempranas del proyecto, es una mejor práctica para fomentar la innovación responsable. Esto asegura que las consideraciones éticas no sean una ocurrencia tardía, sino que estén entrelazadas en el tejido mismo del desarrollo tecnológico.

VIII. Hacia una respuesta crítica y proactiva

VIII.1. Propuestas de gobernanza y políticas institucionales

El diagnóstico de las tensiones filosóficas y prácticas en torno a la IAGen en el contexto boliviano exige una respuesta proactiva. La primera medida, y la más urgente, es el desarrollo de políticas claras y un código de conducta para el uso de la IA en la academia y la investigación. Esta gobernanza no debe ser un simple adorno discursivo, sino un marco estructurante del ciclo tecnológico, adaptable y resiliente.

Dichas políticas deben incluir:

1. Una declaración obligatoria del uso de IA. Inspirada en la propuesta de Ansari (2024), esta medida de transparencia es fundamental para restaurar el principio de que todo conocimiento es situado y debe responder por su proceso de construcción.

2. Mecanismos de auditoría algorítmica y protocolos de respuesta frente a fallas. Esto permitirá abordar tanto la opacidad algorítmica como la falta de transparencia que preocupan a los investigadores.

3. Directrices claras sobre la propiedad intelectual y la privacidad de los datos. Dado que las plataformas operan con modelos opacos, es crucial establecer protocolos para el consentimiento informado y el resguardo de la información proporcionada por los usuarios, evitando así la vigilancia algorítmica o el uso indebido.

4. Colaboración interdisciplinaria. La implementación de estos marcos debe ser un esfuerzo co-creado, que involucre a técnicos, académicos de ciencias sociales, humanistas y expertos en derecho, reconociendo que los desafíos de la IA son técnicos, éticos y sociales.

VIII.2. La formación como base para una razón crítica

El problema de la IAGen no es solo tecnológico, sino de alfabetización crítica. La falta de formación sistemática en el uso de estas herramientas es una barrera estructural. Por tanto, la formación no debe ser meramente técnica, sino que debe promover una alfabetización crítica que permita a los usuarios entender la IAGen como una herramienta con limitaciones inherentes y no como una “caja mágica.”

Esta capacitación debe centrarse en cómo la IA complementa –y no sustituye– la labor humana, enfatizando el valor del juicio crítico, el análisis interpretativo y la abducción, que son capacidades exclusivamente humanas y que no pueden ser replicadas por un sistema que opera sobre la base de la inducción y la asociación. Se propone la revisión de los currículos y los mecanismos de evaluación para fomentar el pensamiento de orden superior y la capacidad de discernimiento que la IA no puede replicar, y que Rousseau (1750/2001) consideraba esenciales para una vida virtuosa.

IX. Epílogo: La reconciliación de la razón en la acción

El artículo ha demostrado cómo la inteligencia artificial generativa, lejos de ser un avance tecnológico neutral, es una manifestación de profundas tensiones éticas y filosóficas que se remontan a la modernidad. Al encarnar la razón instrumental de Horkheimer (1947/1973), la IAGen reduce el conocimiento a una mera calculabilidad y, al operar bajo la lógica del progreso sin virtud, como temía Rousseau (1750/2001), puede corroer la autenticidad y el juicio humano.

La respuesta al desafío de la IAGen en un contexto incipiente como el de Bolivia no reside en su rechazo, sino en una profunda y autocrítica reflexión filosófica. La tarea es reconocerla como una herramienta poderosa, pero ciega, que debe ser guiada por la conciencia y la virtud del ser humano. Esto exige la creación de marcos institucionales que garanticen la integridad y la transparencia, así como una formación que empodere a los individuos con la capacidad de ejercer un juicio crítico y moral frente a la eficiencia tecnológica. Al asumir esta responsabilidad, la humanidad, a través de la filosofía y el juicio, debe dirigir el camino de la razón y no dejarse arrastrar por el mero progreso instrumental. Solo de esta manera se puede preparar el camino para una reconciliación de la razón, en la que la eficiencia técnica no esté reñida con los fines últimos de la justicia, la verdad y la integridad.

Reconocimientos

Se agradece profundamente la contribución de herramientas de inteligencia artificial generativa (IAGen) en la elaboración de este artículo. Específicamente, se ha recurrido a Deepseek, Perplexity, NotebookLM y Gemini como asistentes metodológicos. Estas plataformas han sido fundamentales para organizar, sistematizar y procesar la vasta cantidad de información contenida en las fichas de resumen de cada uno de los textos consultados, permitiendo una identificación más eficiente de los conceptos clave y las conexiones entre las fuentes. Su capacidad para traducir textos también facilitó el acceso a información relevante, optimizando el tiempo y los recursos de la investigación. Es crucial recalcar que estas herramientas han sido utilizadas estrictamente como un apoyo técnico y operativo, sin asumir en ningún momento la función de coautoría o de sustitución del análisis crítico y la interpretación humana. La autoría intelectual de este trabajo corresponde enteramente al investigador.

Referencias

Ansari, M. I. Z. (2024). Unwavering Threat of Generative Artificial Intelligence and Frightening Future of Business Researches in Public Policy and Social Science Domains [La amenaza constante de la inteligencia artificial generativa y el aterrador futuro de las investigaciones empresariales en los ámbitos de las políticas públicas y las ciencias sociales.]. International Journal of Research in Business Studies, 9(2).

Benavides-Lara, M. A., Rendón Cazales, V. J., Escalante Rivas, N., Martínez Hernández, A. M. del P., & Sánchez Mendiola, M. (2025). Presencia y uso de la inteligencia artificial generativa en la Universidad Nacional Autónoma de México. Revista Digital Universitaria, 26(1). https://doi.org/10.22201/ceide.16076079e.2025.26.1.10

Borges, J. L. (1987). La Biblioteca de Babel. En Ficciones (14a reimp., pp. 89-100). Alianza Editorial. (Obra original publicada en 1941)

Dick, P. K. (1968). ¿Sueñan los androides con ovejas eléctricas? Escuela de Filosofía Universidad ARCIS.

Domínguez-Caiza, J. L. (2025). El reto de la inteligencia artificial ante la investigación en ciencias sociales. Revista Científica Hallazgos21, 10(1), 60–70. http://revistas.pucese.edu.ec/hallazgos21

Etesse, M. (2024). Introducción al análisis de datos cualitativos con inteligencia artificial: Guía práctica para usar ChatGPT en la investigación social y educativa. Pontificia Universidad Católica del Perú, Facultad de Ciencias Sociales. https://doi.org/10.18800/978-612-4355-17-26

Horkheimer, M. (1973). Crítica de la razón instrumental (2.ª ed.). Editorial SUR, S. A. (Obra original publicada en 1947)

Kundera, M. (1994/2003). Los testamentos traicionados. Tusquets Editores.

Larson, E. J. (2022). El mito de la Inteligencia Artificial: Por qué las máquinas no pueden pensar como nosotros lo hacemos (M. J. Krmpotić, Trad.). Shackleton Books, S. L.

Law, R., Ye, H., & Lei, S. S. I. (2025). Ethical artificial intelligence (AI): Principles and practices [Inteligencia artificial (IA) ética: principios y prácticas]. International Journal of Contemporary Hospitality Management, 37(1), 279–295. https://doi.org/10.1108/IJCHM-04-2024-0482

Perezchica-Vega, J. E., Sepúlveda-Rodríguez, J. A., & Román-Méndez, A. D. (2024). Inteligencia artificial generativa en la educación superior: usos y opiniones de los profesores. European Public & Social Innovation Review, 9, 1–20. https://doi.org/10.31637/epsir-2024-593

Rousseau, J.J. (2001). Discurso sobre las ciencias y las artes. En Discurso sobre las ciencias y las artes; Discurso sobre el origen de la desigualdad entre los hombres; El contrato social (pp. 19-52). Editorial LIBSA. (Obra original publicada en 1750)

Runcan, R., Hațegan, V., Toderici, O., Croitoru, G., Gavrila-Ardelean, M., Cuc, L. D., Rad, D., Costin, A., & Dughi, T. (2025). Ethical AI in Social Sciences Research: Are We Gatekeepers or Revolutionaries? [Inteligencia artificial ética en la investigación en ciencias sociales: ¿Somos guardianes o revolucionarios?] Societies, 15(3), 62. https://doi.org/10.3390/soc15030062

Spedding, A. (2004). De cuando en cuando Saturnina / Saturnina From Time to Time: Una historia oral del futuro. Editorial Mamahuaco.

UNESCO. (2024). Guía para el uso de IA generativa en educación e investigación. https://www.unesco.org/es/open-access/cc-sa

Nota: Declaro que ningún tipo de conflicto de intereses ha influido en la elaboración de este artículo.